Techniczne SEO powinno być jednym z pierwszych kroków w optymalizacji strony pod kątem wyszukiwarek. Dzięki niemu Twoje treści będą widoczne i czytelne nie tylko dla użytkowników, ale również dla wyszukiwarek.

W tym artykule dowiesz się, które aspekty technicznego SEO są najważniejsze, czy jest to tak trudne, jak ludzie mówią, i jak krok po kroku sprawdzić techniczne SEO twojej strony za pomocą Marketing Miner.

Czym jest techniczne SEO?

Techniczne SEO to część SEO, która jest odpowiedzialna za to, aby Twoja witryna została odkryta, zaindeksowana i ostatecznie wyświetlona w wynikach wyszukiwania przez wyszukiwarki.

Spełniając wymagania techniczne wyszukiwarek (zazwyczaj wymagania te są ustandaryzowane, więc nie musisz dostosowywać się inaczej do każdej wyszukiwarki), zapewniasz szybsze i łatwiejsze odnalezienie Twojej strony przez crawlera.

Techniczne czynniki SEO

Do najważniejszych czynników technicznych SEO należą:

- Architektura stron internetowych

- Struktura adresów URL

- Mapa strony XML

- Robots.txt

- Kanonizacja i zduplikowana treść

- Przekierowania i uszkodzone strony

- Przyjazność dla urządzeń mobilnych

- Certyfikat SSL (HTTPS)

- Szybkość ładowania

- Dane strukturalne

- Optymalizacja przemieszczania się crawlera po sieci (crawl budget)

- Hreflang - dla stron wielojęzycznych

Najpierw jednak wyjaśnijmy, jak działają wyszukiwarki i jaki jest proces odkrywania, indeksowania i wyświetlania Twojej strony w wyszukiwarce.

Przeszukiwanie, renderowanie i indeksowanie

Są to prawdopodobnie 3 najważniejsze słowa, które powinieneś znać w ramach technicznego SEO, ale także w ramach SEO w ogóle. Są to zasady, na których opierają się wyszukiwarki.

Crawling

Crawling - przeszukiwanie sieci przez robota.

Aby Twoja strona pojawiła się w wynikach wyszukiwania, musi zostać najpierw odkryta przez crawlera. Crawler porusza się po Internecie, korzystając z linków, aby odkryć nowe strony.

Poniższe czynniki mogą ułatwić proces indeksowania i zwiększyć jego wpływ:

- Tworząc plik robots.txt

- Optymalizacja przejścia crawlera przez witrynę - blokowanie dostępu crawlera do sekcji, w których nie ma ważnych treści (sekcja administratora, sekcja użytkownika...)

- Zaprojektowanie właściwej architektury strony

- Tworzenie sitemapy XML i łączenie jej z Google Search Console

- Optymalizacja linkowania wewnętrznego

Poniżej opiszemy te kroki bardziej szczegółowo.

Renderowanie

Renderowanie - renderowanie Twojej strony przez roboty.

Rendering jest procesem, w którym crawler ładuje i renderuje Twoją stronę. Rendering jest używany przez crawlera w niewielkim procencie przypadków, gdy renderuje on całą zawartość strony, w tym JavaScript. W przypadku witryn JS, w ten sposób widzi, co tak naprawdę tam jest.

W większości przypadków jednak wyszukiwarki nie mają dostępu do renderowania i dlatego muszą serwować ważne treści na stronie bez JS w HTML.

Jeśli chcesz zobaczyć jak Googlebot (lub inny crawler) widzi Twoją stronę bez renderowania, wyłącz na chwilę JavaScript na swojej stronie.

W przypadku Google Chrome wyłącz JS w konsoli programisty. Przejdź do Konsoli (prawy przycisk myszy -> Inspect), a następnie kliknij na ikonę koła zębatego.

Teraz wystarczy kliknąć na Disable JavaScript w podsekcji Debugger, odświeżyć stronę i zobaczysz swoją stronę tak, jak widziałaby ją wyszukiwarka, gdybyś nie użył renderingu.

Tak wygląda strona https://www.marketingminer.com/pl/features/keyword-research z włączoną obsługą JavaScript (tak widziałby ją Googlebot, gdybyś wyrenderował całą stronę łącznie z JS):

A tak to wygląda po wyłączeniu JS (tak widziałby to Googlebot w większości przypadków, w których nie renderowałby tego tekstu):

Czy zauważyłeś różnicę?

Oprócz pola wyszukiwania profilera (co nie byłoby problemem), zniknął również główny nagłówek H1 "Analiza słów kluczowych", który jest generowany za pomocą JS. To już jest problem, ponieważ wyszukiwarka może mieć problem ze zrozumieniem, o czym jest ta strona.

INFO: Od 12/13/2022 r. ten problem jest już naprawiony, więc nie będziesz go widział :)

Pamiętaj więc, żeby zawsze generować ważne treści na stronie (nagłówki, podtytuły, tabele, akapity, etykiety...) bezpośrednio w kodzie źródłowym, używając HTML, a nie JS.

WSKAZÓWKA: Jeśli chcesz dowiedzieć się więcej o renderowaniu, polecam przeczytać ten artykuł: https://www.searchenginejournal.com/rendering-seo-introduction/330399/

Indeksowanie

Indeksowanie - zapisanie strony w bazie danych.

Jeśli powyższe dwa kroki zostaną spełnione, a robot indeksujący przeszukał Twoją stronę, pomyślnie ją ocenił i uznał, że treść na tej stronie jest wartościowa, umieści ją w indeksie.

Z punktu widzenia wyszukiwarki indeks to baza danych zawierająca treści, które wyszukiwarka przechowuje i wykorzystuje w swoich wynikach wyszukiwania.

WSKAZÓWKA: Cały proces przeszukiwania, renderowania i indeksowania strony można zobaczyć na poniższym obrazku:

Źródło: https://developers.google.com/search/docs/crawling-indexing/javascript/javascript-seo-basics

Architektura strony internetowej

Tak jak każdy dom, strona internetowa musi mieć zaprojektowaną odpowiednią architekturę. Architektura strony powinna być oparta na analizie słów kluczowych.

Architektura strony to sposób, w jaki hierarchicznie zorganizowałeś poszczególne strony docelowe na stronie.

Poniższy obrazek podpowie ci, jak powinna wyglądać idealna architektura strony:

Łącząc każdą stronę docelową za pomocą linków wewnętrznych (np. strona główna -> kategoria -> podkategoria -> produkt), zapewniasz, że indeksator dotrze do każdej strony, którą chcesz zaindeksować.

Wręcz przeciwnie, ta propozycja struktury strony jest nieprawidłowa:

Powstały tzw. strony osierocone, czyli strony, do których nie prowadzi żaden link wewnętrzny ze strony nadrzędnej w architekturze witryny, a wyszukiwarka w takim przypadku nie dociera do nich i nie ma szans na umieszczenie ich w indeksie.

Są to strony:

- Produkt 1, 2 i 3, które wprawdzie są ze sobą powiązane, ale robot, który dociera do strony głównej, nie ma możliwości ich odnalezienia, ponieważ nie prowadzi do nich żaden link wewnętrzny ze strony głównej.

- Produkt 10 - również nie ma do niego wewnętrznego linku.

WSKAZÓWKA: Jeśli masz już istniejącą stronę, możesz wykonać wizualizację architektury swojej strony za pomocą tego narzędzia: http://www.visualsitemapper.com/

Podgląd dla witryny https://www.marketingminer.com

Struktura adresów URL

Podstawową zasadą przy tworzeniu adresów URL jest to, że nie powinny się one nigdy zmieniać w czasie.

Adresy URL powinny być proste i znaczące, tak aby można było na ich podstawie stwierdzić, czego użytkownik szuka na danej stronie.

Jest to szczególnie przydatne, gdy udostępniasz dany adres URL w mediach społecznościowych.

Użytkownik na pewno szybciej zrozumie, co znajduje się na danej stronie, jeśli udostępni ten adres:

https://www.marketingminer.com/pl/blog/analiza-slow-kluczowych.html

Jakbyście mieli taki adres URL:

https://www.marketingminer.com/sk/blog/p=?12389

Więcej informacji na temat struktury adresów URL znajdziesz bezpośrednio na blogu Google: https://developers.google.com/search/docs/crawling-indexing/url-structure

Mapa strony XML

Sitemap (mapa strony) to plik XML, który powinien zawierać informacje o wszystkich ważnych stronach docelowych, plikach, obrazach i filmach, które chcesz, aby Google odkrył, przeszukał i zaindeksował.

Sitemap jest drugim najważniejszym źródłem informacji dla Googlebota, który znajduje nowe adresy URL. Jeśli więc nie masz jeszcze utworzonej sitemapy, to najwyższy czas.

Większość systemów zarządzania treścią automatycznie tworzy plik sitemapy i dodaje do niej nowo utworzone strony docelowe.

Po utworzeniu sitemapy nie zapomnij dodać jej do Google Search Console w sekcji Sitemap Files. Tam też dowiesz się, czy twoja sitemapa jest ważna:

Więcej informacji o tym, jak stworzyć sitemapę, na co zwrócić uwagę i jak dodać ją do GSC, znajdziesz w tym artykule: https://help.marketingminer.com/cs/clanek/co-je-to-sitemap-xml-a-jak-ji-vytvorit/

Robots.txt

Robots.txt to plik tekstowy, którego możesz użyć do wskazania stron lub plików, które robot (najczęściej robot indeksujący wyszukiwarki) powinien lub nie powinien indeksować. Dobrym standardem jest również umieszczanie w robots.txt lokalizacji plików sitemap.

Poniżej możesz zobaczyć przykładowy plik MM robots.txt, który można znaleźć pod tym adresem: https://www.marketingminer.com/robots.txt.

Jeżeli określona strona lub sekcja jest zablokowana w robots.txt, indeksator nie będzie nawet próbował pobrać tego adresu, oszczędzając w ten sposób czas. Natomiast w przypadku wdrożenia noindex musi najpierw pobrać adres URL, a potem go ocenić.

Jeśli więc chcesz uniemożliwić indeksowanie jakiejś sekcji (np. Administracja, profil użytkownika...), lepiej jest sięgnąć po blokadę w robots.txt niż zastosować tag noindex.

WSKAZÓWKA: Zastanawiasz się, jaka jest prawidłowa składnia pliku robots.txt i jak sprawdzić jego działanie? Przeczytaj nasz obszerny przewodnik dla robots.txt: https://help.marketingminer.com/pl/artykul/robots-txt-co-to-jest-i-jak-dziala/

Kanonizacja i zduplikowana treść

Duplikaty treści są często tworzone, kiedy w sieci pojawiają się problemy techniczne. Duplikat treści pojawia się, gdy unikalna treść (identyczna treść lub treść o tej samej wartości dodanej dla użytkownika) nie znajduje się na wielu różnych adresach URL.

Przykłady tego, co najczęściej powoduje duplikację treści w sieci, a co wymaga technicznego rozwiązania:

- Zmienianie nazw i języków

- Wersje mobilne i desktopowe

- AMP i non-AMP wersja

- www i non-www wersja

- Adresy URL dostępne przez duże i małe litery

- Jeden artykuł/produkt dostępny w różnych kategoriach

- Parametry URL, które nie zmieniają treści na stronie (a jedynie jej wygląd, np. listing kafelkowy) i jednocześnie nie zawierają tagu kanonicznego

- Parametry śledzące w adresach URL

- Nieprzetworzone adresy URL z ukośnikiem "/" i bez ukośnika "/" na końcu

- …

Wszystko to powinno być traktowane jako część technicznego SEO przy użyciu tagu kanonicznego.

Znacznik kanoniczny (lub rel="canonical") to element HTML, który pozwala przekazać indeksującemu informację, że adres URL, który jest indeksowany, jest duplikatem i pod jakim adresem znajduje się jego oryginalna wersja.

Dzięki prawidłowemu zastosowaniu elementu kanonicznego możesz zapobiec problemom związanym z duplikatami treści i skierować indeksatora do korzystania z właściwej wersji treści..

Przekierowania i uszkodzone strony

Sprawdzanie funkcjonalności linków wewnętrznych (ale także zewnętrznych) w Twojej witrynie powinno być regularną częścią technicznego SEO. Jeśli linkujesz do nieistniejących stron w swoim serwisie, możesz obniżyć swój autorytet w oczach nie tylko wyszukiwarek, ale nawet użytkowników.

Linki do nieistniejącej strony często nie są twoją winą. Ktoś na stronie mógł kliknąć i wpisać zły adres URL, albo strona, do której linkujesz, już nie istnieje i nie została nawet przekierowana na istniejącą stronę.

W takim przypadku ani użytkownik, ani wyszukiwarka nie dotrą do miejsca, do którego chcieli dotrzeć, co może stanowić problem, zwłaszcza podczas odkrywania innych stron w Twojej witrynie za pomocą nawigacji indeksującej.

WSKAZÓWKA: Przeczytaj instrukcję, jak krok po kroku sprawdzić, czy na twojej stronie nie ma uszkodzonych linków za pomocą programu Marketing Miner: https://help.marketingminer.com/pl/artykul/broken-link-checker/

Sprawdzanie przekierowań jest również ważne, by nie wprowadzać niepotrzebnie w błąd crawlera poprzez nieprawidłowe kody statusu lub nie marnować budżetu crawlera na łańcuchy przekierowań.

Sprawdź na swojej stronie:

- Przekierowania z kodem statusu 302 i sprawdź, czy rzeczywiście jest to tylko tymczasowe przekierowanie. Jeśli nie, użyj zamiast niego kodu statusu 301.

- Sprawdź, czy w twojej witrynie występują łańcuchy przekierowań, a jeśli tak, to usuń je, przekierowując ze strony oryginalnej na stronę docelową za pomocą kodu statusu 301 (bez dodatkowych, niepotrzebnych przekierowań, które obciążają wyszukiwarkę i wydłużają czas ładowania strony).

WSKAZÓWKA: Jak sprawdzić kody statusu krok po kroku, można znaleźć tutaj: https://help.marketingminer.com/pl/artykul/kod-statusu/

Doświadczenie użytkownika (doświadczenie strony)

W ostatnich latach Google dodaje do sygnałów rankingowych coraz więcej metryk wpływających na doświadczenie użytkownika. Na przykład:

- Przyjazność dla urządzeń mobilnych (mobile friendly)

- Bezpieczeństwo przeglądania (bezpieczeństwo HTTPs)

- Szybkość ładowania (Core Web Vitals)

Dostosowywanie tych metryk powinno być również częścią Twojego technicznego SEO.

Poniżej omówimy je bardziej szczegółowo.

Przyjazność dla urządzeń mobilnych

Zdecydowana większość odwiedzin pochodzi z urządzeń mobilnych, dlatego optymalizacja strony pod kątem urządzeń mobilnych jest koniecznością.

Możesz sprawdzić, czy Twoja strona jest zoptymalizowana pod kątem urządzeń mobilnych w GSC w sekcji Mobilna Przyjazność:

Certyfikat SSL (HTTPS)

Protokół HTTPS chroni komunikację między przeglądarką a serwerem przed ingerencją napastników.

Istnieją różne darmowe certyfikaty SSL, takie jak Let’s encrypt, które zabezpieczają tę szyfrowaną komunikację.

Dlatego Twoja strona powinna działać w protokole HTTPS, a nie HTTP.

Szybkość ładowania (Core Web Vitals)

Szybkość ładowania strony staje się stopniowo jednym z podstawowych elementów składowych użytecznej sieci. Użytkownicy stają się coraz bardziej wymagający, a sieć od dawna odchodzi od złożoności na rzecz szybkości i prostoty. Dlatego warto sprawdzać szybkość ładowania się strony, optymalizować ją i identyfikować słabe punkty.

Szybkość ładowania strony ma również wpływ na SEO. Jeśli strona nie ładuje się wystarczająco szybko, użytkownik porzuci ją i wróci do wyników wyszukiwania, co może mieć negatywny wpływ na Twoje rankingi.

W 2021 roku Google dodało również nowe sygnały rankingowe Core Web Vitals, które są oparte na doświadczeniu użytkownika (UX). Na poniższym obrazku możesz zobaczyć, jakie to są konkretne metryki:

Źródło: https://webmasters.googleblog.com/2020/05/evaluating-page-experience.html

Możesz przetestować zarówno szybkość ładowania, jak i wskaźniki Core Web Vitals, korzystając z narzędzia PageSpeed Insights: https://pagespeed.web.dev/

Narzędzie to powie Ci, które rzeczy powodują spowolnienie Twojej strony i jak powinieneś je naprawić. Mając taki raport, możesz skontaktować się ze swoim programistą, który powinien być w stanie Ci w tym pomóc.

Kilka sposobów na to, by Twoja strona ładowała się szybciej:

- Optymalizacja rozmiaru i wymiarów obrazów

- Buforowanie strony

- Kompresja Gzip

- Zmniejszenie liczby żądań HTTP

- Minifikacja JS, CSS i HTML

- Usunięcie łańcuchów przekierowań

- Usunięcie blokujących renderowanie skryptów JavaScript

- Zmniejszanie liczby ładowanych zewnętrznych skryptów

- …

WSKAZÓWKA: Polecam zbiorcze sprawdzenie szybkości ładowania całej witryny za pomocą programu Marketing Miner i poprawienie najwolniejszych (lub najbardziej krytycznych dla biznesu) stron docelowych: https://help.marketingminer.com/pl/artykul/szybkosc-strony/

Dane strukturalne

Wdrożenie danych strukturalnych nie ma bezpośredniego wpływu na poprawę rankingów Twojej witryny. Ma jednak wpływ na poprawę współczynnika klikalności (CTR) z wyszukiwania, ponieważ są one bardziej interesujące i zajmują więcej miejsca w SERPach w porównaniu z tradycyjnymi wynikami tekstowymi.

Strona Schema.org zawiera ustandaryzowaną listę znaczników, które są obsługiwane przez wszystkie główne wyszukiwarki - Google, Bing, Yahoo i Yandex. Schema.org obsługuje wiele formatów znaczników, ale najczęściej spotykane to:

- JSON-LD

- Microdata

- RDF

Przykładowy wynik wyszukiwania z danymi strukturalnymi:

Który wynik wyszukiwania zainteresował Cię bardziej?

Pierwsza strona ma wprowadzone dane strukturalne (gwiazdki, ocena, liczba recenzji, obrazek...), a druga nie.

Strona Schema.org zawiera ustandaryzowaną listę znaczników, które są obsługiwane przez wszystkie główne wyszukiwarki - Google, Bing, Yahoo i Yandex. Schema.org obsługuje wiele formatów znaczników, ale najczęściej spotykane to:

- JSON-LD

- Microdata

- RDF

WSKAZÓWKA: Zobacz, jakie znaczniki danych strukturalnych obsługuje Google i jak są one widoczne w wyszukiwarce: https://developers.google.com/search/docs/appearance/structured-data/search-gallery

Crawl budget - budżet indeksowania

Crawl budget to ilość adresów URL, które indeksator może przeszukać w określonym czasie. Najczęściej podaje się go jako liczbę adresów URL, które indeksator może przeszukać w ciągu jednego dnia. Jest ona określana przez wiele czynników. Do najważniejszych z nich należą:

- jakość i ilość nowo odkrytych unikalnych treści

- szybkość ładowania strony

- struktura wewnętrznego linkowania.

Wyszukiwarki przydzielają budżet na indeksowanie strony głównie na podstawie jej autorytetu (portfolio linków) i ilości unikalnej/jakościowej treści, którą są w stanie pobrać.

W trakcie przeszukiwania sieci przez crawlera należy zająć się problemem "crawl waste". Crawl waste to zapytania, które kierują do nieistniejących stron lub stron, których nie chcemy indeksować.

WSKAZÓWKA: Więcej informacji o budżecie na indeksowanie znajdziesz w tym poradniku: https://help.marketingminer.com/pl/artykul/co-to-jest-budzet-na-raczkowanie/

Hreflang

Jeśli zarządzasz stroną wielojęzyczną, atrybut hreflang będzie twoim pomocnikiem. Pomoże Ci on poprawić międzynarodowe, regionalne targetowanie, a także rozwiązać problem duplikatów językowych.

Wszystko, co musisz wiedzieć o witrynach wielojęzycznych i wdrażaniu atrybutu hreflang, znajdziesz w oficjalnych instrukcjach Google.

Najczęstsze problemy związane z technicznym SEO

Najczęstsze problemy związane z technicznym SEO, które możesz napotkać na swojej stronie, to:

- Problemy z indeksowaniem strony - zablokowane indeksowanie w robots.txt (często widzimy deweloperów blokujących całą witrynę przed indeksowaniem w robots.txt) lub wdrożone noindex.

- Wersja HTTP - witryna działa na niezabezpieczonej wersji HTTP

- Powolne ładowanie strony - duże obrazy, dużo wtyczek w systemach zarządzania treścią, które ładują zewnętrzne skrypty JS

- Nieprawidłowo umieszczony tag kanoniczny

- Łańcuchy przekierowań

- Uszkodzone strony

- Strony nieresponsywne - niezoptymalizowane dla urządzeń mobilnych

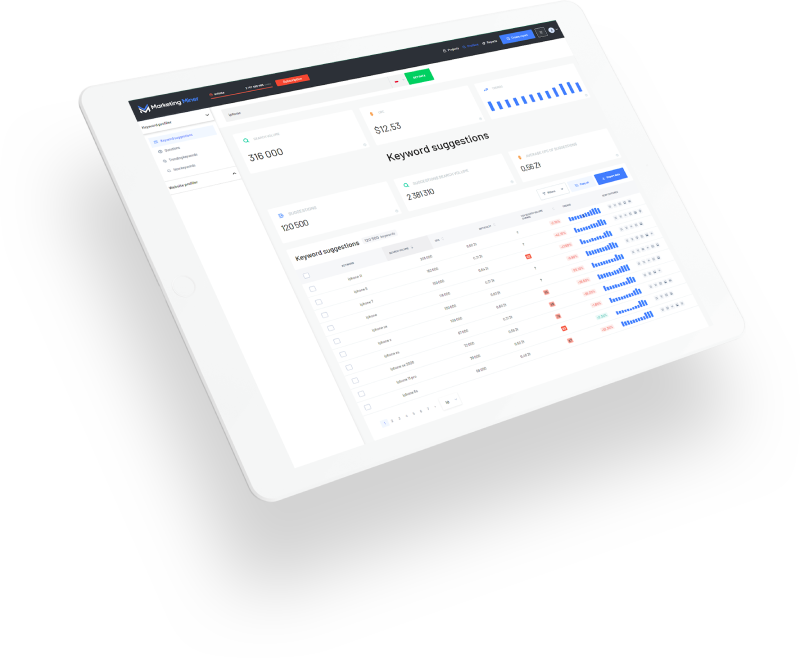

Marketing Miner i techniczne SEO

Jeśli zajmujesz się technicznym SEO, to Marketing Miner będzie doskonałą pomocą. W szczególności będziesz korzystać z sekcji Raporty, w której wybierasz, jakie dane MM ma dla Ciebie zbierać:

- Kod statusu

- Szybkość ładowania

- Walidacja kodu źródłowego

- Sprawdzanie hreflangów

- Kontrola danych strukturalnych

- Sprawdzanie indeksowalności

- Sprawdzanie indeksacji

- Sprawdzanie uszkodzonych linków

W kolejnym kroku wstaw sitemapę swojej strony:

Wszystko, co musisz zrobić, to sprawdzić wprowadzone dane i kliknąć na Przetwarzanie raportu.

Marketing Miner wygeneruje raport z aktualnymi danymi w przejrzystej tabeli, który możesz pobrać do Excela i sprawdzić, jak i czy poprawnie wykonałeś powyższe czynności.

WSKAZÓWKA: przykładowy MM raport: https://www.marketingminer.com/pl/report/55173ab334db08b8ce5327d5042269fae9e18c3a6861a151597cc2a10bf135fd/visualize

Techniczne narzędzia SEO

Te narzędzia SEO pomogą Ci i ułatwią pracę, kiedy będziesz zajmować się technicznym SEO:

- Marketing Miner - masowa eksploracja danych URL

- Google Search Console - problemy techniczne napotykane przez Googlebota podczas przeszukiwania twojej strony

- Screaming Frog SEO Spider - desktop crawler

- Visual Site Mapper - wizualizacja architektury strony

- PageSpeed Insights - sprawdzanie prędkości ładowania i metryk Core Web Vitals

- Chrome DevTools - bardziej odpowiednie dla programistów

- Schema Validator - narzędzie do testowania danych strukturalnych

Podsumowanie: czy techniczne SEO jest skomplikowane?

Często spotykamy się z dyskusjami, że techniczne SEO jest trudne i powinni się nim zajmować przede wszystkim programiści, którzy z kolei odsyłają do specjalistów SEO.

Dzisiejsze systemy zarządzania treścią lub rozwiązania dla e-commerce w większości przypadków poprawnie rozwiązują kwestię technicznego SEO i istnieje wiele wtyczek, które ułatwiają optymalizację witryny bez potrzeby korzystania z pomocy programistów (np. różne wtyczki do generowania sitemapy, rozmieszczania danych strukturalnych, atrybutu hreflang...).

Jeśli jednak Twoja strona działa na niestandardowym rozwiązaniu lub nie jesteś pewien pewnych kwestii technicznych, zawsze lepiej skontaktować się z programistą, który pomoże Ci w tej kwestii, niż ryzykować późniejsze problemy z widocznością w wyszukiwarkach, które ostatecznie mogą mieć negatywny wpływ na Twoje zyski.